在一般的 VM 中,會使用許多的 vdisk, 但一台 VM 總是只能放在一台實體主機上,這也代表著VM只由一個 nutanix CVM (Controller VM)在服務著。在絕大部分的狀態下,都是充足夠用。

而 nutanix ABS 服務,一次可以由多個CVM服務同一台VM,它將 nutanix 叢集變成一座 scale out iscsi Storage。在節點多的情況下,有 round-robin 加持下,效能會有更佳的表現。

簡單通俗的講:

第一種方式是由一位服務員來服務一位客戶,第二種方式是用更多的服務員服務一位客戶。

但第一種方式簡單且服務品質也夠好了,我大部分的狀況都選擇第一種就很夠用。

Step 1: 先確定 IP data service 有設定,這是給 iscsi initiator (your VM) 對應的 IP (iscsi Storage, also known as nutanix),nutanix 之後會再分流。

Step 2: 從 Storage -> + Volume Group。建一個新的 volume group

Step 3: 加入 New Disk,最好超過 4 個,一次多個 CVM 進行分流服務

Step 4: 增加 CLIENT IQN

Step 5: 在 VM 裡安裝 iscsi 套件

Step 6: 修改虛擬機內的 iqn,iqn必為唯一,跟地址一樣

Step 6.5: 有時候,虛擬機要另外新增一個 vNIC,通到 CVM 的網段,才能透過 Data Service IP掛載。

Step 7: 掛載 iscsi LUNs,用下列的指令。

Discovery :

“iscsiadm –mode discoverydb –type sendtargets –portal 10.21.41.38 –discover”

Login:

“iscsiadm –mode node –portal 10.21.41.38:3260 –login”

Logout:

“iscsiadm –mode node –portal 10.21.41.38:3260 –logout”

List node records:

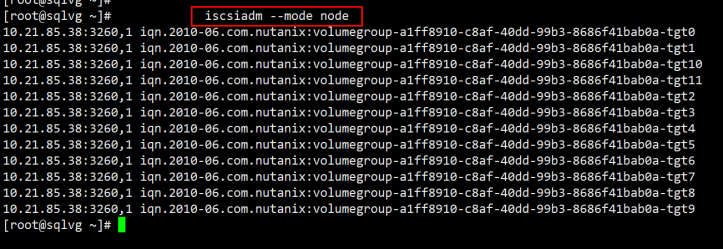

“iscsiadm –mode node”

Step 8: 做出來之後,在 nutanix Prism 看到如下圖:

在 VM 裡看到如下圖:

後話:

看起來就像上面這樣。順利的話 10 分鐘以內打完收工。

如果想了解 nutanix software 分流的狀況,

最直接的方法是在 VM 裡跑 netstat -an | grep 3205

並且最棒的是…路徑分流等等這些都是全自動在做。就算有 CVM 停機,路徑也會全自動切換到其他 CVM,不會造成中斷影響。(my 4 CVMs: IP 29-32)

還有最後一件事:理論上配合 LACP 應該更佳,但實際上 LACP 帶來的效益還遠及不上付出的代價。所以用不用 LACP 看個人想法囉。